Durch den einfachen Zugang zu Deepfake-Technologien wuchsen die Betrugsfälle allein in den USA um das Zehnfache. Das EU-Parlament hat im Juni 2023 den "AI Act" verabschiedet, der den Einsatz von KI-Technologien durch KI-Detektoren in der EU regulieren soll. // von Sophie Pfeffer und Casimir Ruttka

Deepfakes werden mithilfe von künstlicher Intelligenz und Machine Learning erstellt. Daraus entstehen hochentwickelte digitale Manipulationen von audiovisuellen Inhalten. Sie ermöglichen es, Gesichter und Stimmen von Personen in Videos, Fotos und Audio nahezu perfekt zu fälschen, sodass sie authentisch und glaubwürdig erscheinen. Durch solche Fälle wird die Grenze zwischen Realität und Virtualität verwischt und macht es für den durchschnittlichen Internet-Nutzer schwierig, Falschinformationen aus dem Weg zu gehen. Der Einsatz von Deepfakes in Betrugsmaschen ist in den USA binnen eines Jahres von 0,2 Prozent auf 2,6 Prozent gestiegen, so die Studie von sumsub.

Es gibt verschiedene Arten von Deepfakes, darunter Gesichts-Deepfakes, bei denen das Gesicht einer Person in ein fremdes Video oder Bild eingefügt wird, und Voice-Deepfakes, bei denen die Stimme einer Person mithilfe von KI nachgeahmt wird. Noch eine Art der Deepfakes sind Text-Deepfakes. Gerade mit der wachsenden Beliebtheit des ChatGPT wird auch dieses Thema immer relevanter.

Große Datensätze für maschinelles Lernen

Deepfakes basieren auf komplexen maschinellen Lernverfahren. "Das KI-Modell wird mit einem großen Datensatz von Stimmaufnahmen, Bildern, Videos gefüttert", erklärt Dr. Nicolas Müller vom Fraunhofer-Institut für Angewandte und Integrierte Sicherheit (AISEC). Durch die Analyse großer Datenmengen werden charakteristische Merkmale einer Person erfasst und in andere Aufnahmen eingefügt. "Verhaltensmuster werden vom KI-Modell aus dem großen Datensatz extrahiert und können dann neu generiert werden."

Neben der Unterhaltungsindustrie werden Deepfakes für politische Manipulationen, Rufschädigung oder die Erzeugung von Fake News verwendet. Die Pornografie-Industrie nutzt Deepfakes, ohne den Konsens der künstlich eingefügten Personen zu beachten. 2018 lag die Zahl der Deepfake-Pornovideos bei knapp 14.000, heute lasse sich keine genau Zahl mehr feststellen, so KI-Experte Henry Ajder im Interview mit "Vollbild".

Deepfakes stellen Integrität von Medien infrage

Die Verbreitung von Deepfakes birgt erhebliche Risiken für die Gesellschaft. Deepfakes können die öffentliche Meinung manipulieren, das Vertrauen in die Medien untergraben und selbst die politische Landschaft destabilisieren. Ein Beispiel ist Volodimir Selenskys vermeintliches Kapitulationsvideo aus dem März diesen Jahres. Deepfakes können zu Rufschädigungen, Cyber-Mobbing und der Verbreitung von Fehlinformationen führen. "Die Gefahr durch Deepfakes wird größer, die Möglichkeiten und Tools nehmen zu und werden natürlich genutzt, um zum Beispiel finanzielle Gewinne durch Betrug zu erzielen", so Professor Dr.-Ing. Peter Eisert, Abteilungsleiter Vision & Imaging Technologies, Fraunhofer Heinrich Hertz Institut. Zudem besteht die Gefahr, dass Deepfakes das Konzept der Authentizität und Wahrheit in Frage stellen.

Erkennung von Deepfakes

Übersicht zu Tipps zur Erkennung von Deepfake von Casimir Ruttka. Quellen: Bundesamt für Sicherheit in der Informationstechnik und Chip.de

Die Erkennung von Deepfakes kann eine Herausforderung sein, da sie zunehmend realistischer werden. Dennoch gibt es Anzeichen wie zum Beispiel Unregelmäßigkeiten im Gesichtsausdruck oder inkonsistente Bewegungen. "Besonders auffällige Fehler bei KIs sind Finger beziehungsweise Hände", erläutert Müller. Das Überprüfen der Quellen, das Vergleichen mit anderen vertrauenswürdigen Quellen und die Nutzung von speziellen Tools zur Deepfake-Erkennung können ebenfalls hilfreich sein. Forscher der Universität Buffalo haben beispielsweise eine Software namens Deepfake-o-meter entwickelt, die die Reflexionen in den Augen mit Echtbildern abgleicht.

Entwickler arbeiten auch an Tools, die mithilfe derselben Deepfake-Technologie falsche Bilder erkennen können. Sie können reale Aufnahmen und bereits existierende Deepfakes zu einer Datenbank zusammenfügen und sie zur Schulung der Detektor-KI verwenden. "Wir haben festgestellt, dass Deepfakes aus öffentlichen Datenbanken meist noch sehr einfach zu erkennen sind", hält Eisert fest. "Auf diese Weise würden die KI-Detektoren nicht gut werden. Deswegen generieren wir bessere Deepfakes, mit denen wir die Algorithmen füttern können."

Deepfake-Technologie ist moralisch neutral

Deepfakes werden durch die rasante Entwicklung in Zukunft immer mehr in den Fokus des Alltages rücken. "Die Technologie ist moralisch neutral und wir müssen dafür sorgen, dass das Missbrauchspotenzial eingedämmt wird, damit auch das gute Potenzial zu Tragen kommt", betont Müller.

Mit der Abstimmung zum KI-Regulierungsgesetz „AI Act“ in der Europäischen Union werden vor allem Gesichtserkennungssoftwares in der Öffentlichkeit ins Visier genommen. Diese treten nach einer Entscheidungsfindung mit dem EU-Mitgliedsstaaten im Jahr 2026 in Kraft. Laut diesem Gesetz müssen dann Deepfakes immer als diese gekennzeichnet werden. „Eine Möglichkeit, mit KI-generierten Inhalten im Kontext von Sozialen Medien umzugehen, wäre die zuverlässige Erkennung von Deepfakes und eine dementsprechende Kenntlichmachung“, erklärt Müller. „Das wäre kein Problem für Kunstschaffende, aber Betrüger würden ausgegrenzt.“

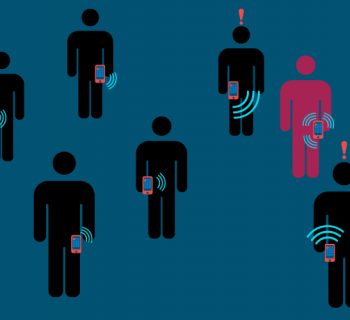

Teaserbild: Deepfake-Technologie wird immer allgegenwärtiger // Casimir Ruttka