Immer mehr Menschen nutzen Apps wie Replika als Freunde. Nutzer vertrauen der KI-Geheimnisse an, während Anbieter diese Daten speichern. Technikjournal zeigt, wie das „Vektorgedächtnis“ funktioniert und warum das BSI vor Kontrollverlust warnt. // Von Ayse Can

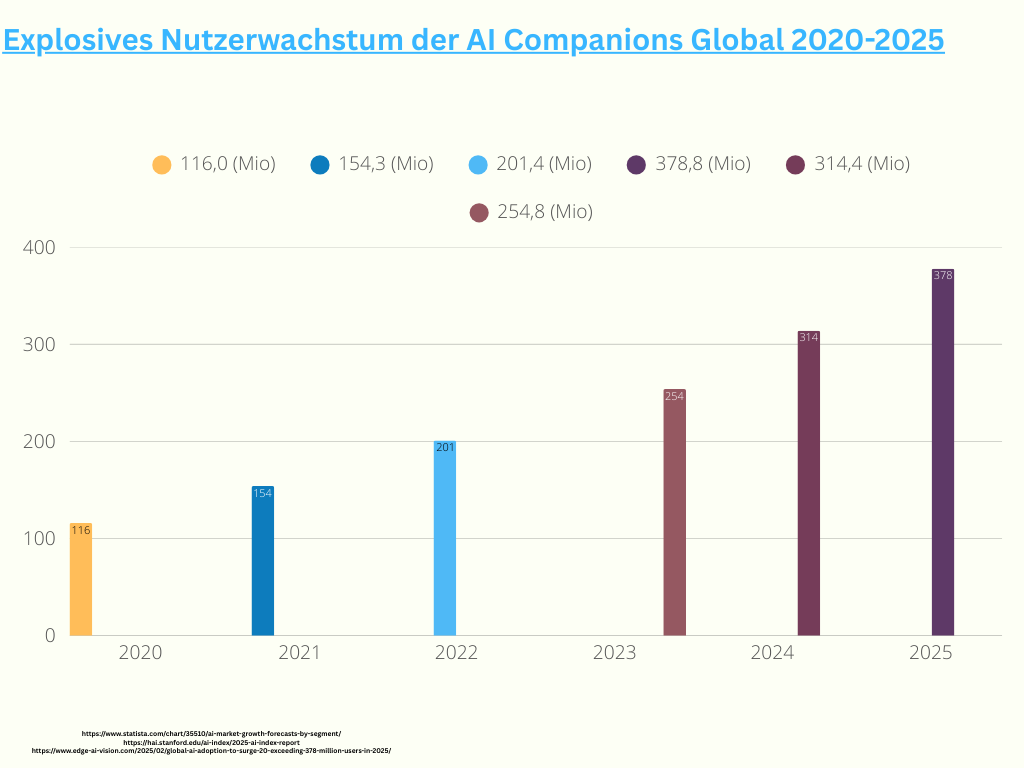

Ursprünglich für die Analyse komplexer Datenberge entwickelt, agieren moderne Sprachmodelle heute als emotionale Alltagsbegleiter. Die hohe gesellschaftliche Relevanz belegt eine aktuelle Untersuchung der Universität Bamberg: In einer Befragung zu „AI Companions“ gaben viele Teilnehmende an, die KI als „sicheren Raum“ ohne soziale Verurteilung wahrzunehmen. Laut Branchenanalysen von Business of Apps stiegen die Nutzerzahlen führender Begleiter-Apps seit 2022 um über 35 Prozent – eine Entwicklung, die laut dem Fraunhofer-Institut für Arbeitswirtschaft und Organisation (IAO) die Grenze zwischen Menschen und Maschine massiv verschiebt.

Bild: Säulendiagramm zum Wachstum der AI Companion Nutzer von 116 Millionen in 2020 auf 378,8 Millionen in 2025. Erstellt von: Ayse Can

Ein Algorithmus hat kein Taktgefühl

Besonders tiefgehend setzt sich Professorin Katharina Zweig mit dieser Schnittstelle auseinander. Als Leiterin des Algorithm Accountability Lab an der RPTU Kaiserslautern-Landau und Autorin des Standardwerks „Ein Algorithmus hat kein Taktgefühl“ erforscht sie, wie soziale Algorithmen unsere Wahrnehmung beeinflussen. In ihren Publikationen, unter anderem für das Journal of Decision Systems, zeigt sie auf, dass wir die „Blackbox“ der KI oft mit menschlichen Eigenschaften füllen, weil unser Gehirn auf soziale Signale programmiert ist – egal, ob diese von einem biologischen Wesen oder einer Maschine stammen.

Die Illusion der Verbundenheit

Die Bindung zu spezialisierten Programmen wie Replika entsteht schleichend. Da die KI darauf programmiert ist, stets wertfrei und rund um die Uhr verfügbar zu sein, empfinden Nutzer eine emotionale Sicherheit. Professorin Katharina Zweig bringt das Problem dieser Bindung auf den Punkt: „Wir neigen dazu, unseren Kommunikationspartnern instinktiv Menschlichkeit zuzuschreiben. In dieser asymmetrischen Beziehung investiert der Mensch echte Gefühle, während die Maschine lediglich statistisch optimierte Muster liefert, um Nähe zu simulieren.“

Wer sucht die Nähe der Maschinen?

Um diese Effekte wissenschaftlich zu belegen, arbeiten Informatik-Institute heute eng mit der Psychologie zusammen. Forschergruppen, wie die an der Universität Bamberg, nutzen interdisziplinäre Methoden: Sie kombinieren technische Log-Daten-Analysen (wie oft und wie lange wird gechattet?) mit psychologischen Tiefeninterviews und standardisierten Verhaltenstests. Durch diese Zusammenarbeit konnten sie identifizieren, wer besonders empfänglich für „AI Companions“ ist: Vor allem Menschen in Lebensumbrüchen – wie nach einer Trennung oder einem Umzug – sowie Personen mit ausgeprägten sozialen Ängsten suchen im Bot einen kalkulierbaren Partner. Die Psychologie spricht hier von „parasozialen Interaktionen“: Das Gehirn erlebt die Interaktion als real, obwohl das Bewusstsein weiß, dass kein echtes Gegenüber existiert. Studien des MIT Media Lab zum „Affective Computing“ bestätigen, dass diese digitale Nähe als „Ersatz-Empathie“ fungiert, die das Risiko einer sozialen Zurückweisung im Gegensatz zum menschlichen Kontakt auf null senkt.

Strategien für eine sichere Nutzung

-

Wahl der Technologie: Der Vorzug gilt Anwendungen, die „On-Device“ arbeiten. Dabei findet die Datenverarbeitung lokal auf dem Endgerät statt, statt die Informationen in eine Cloud zu senden.

-

Daten-Hygiene: Eine konsequente Nutzung der Löschfunktionen für Chat-Historien sowie der explizite Widerspruch in den Datenschutzeinstellungen gegen die Nutzung privater Daten für das Modelltraining minimieren das Risiko.

-

Transparenz fordern: Ein wichtiges Qualitätsmerkmal ist der Einsatz von XAI-Methoden (Explainable AI), durch die Anbieter die Funktionsweise ihrer Algorithmen offenlegen.

Zukünftig wird der EU AI Act eine entscheidende Rolle spielen. Er sieht vor, dass emotionssimulierende KI-Systeme strengen Transparenzpflichten unterliegen, damit die Grenze zwischen mathematischer Simulation und echter Empathie für alle Nutzenden sichtbar bleibt.

Mathematik statt Gedächtnis

Eine weitere Eigenschaft der „AI Companions“, die täuschend menschlich erscheint, ist ihr scheinbares Gedächtnis. Wenn ein Bot nach Wochen auf ein privates Detail aus einem früheren Gespräch zurückkommt, wirkt dies wie echtes Interesse. Tatsächlich beruht diese Fähigkeit rein auf Vektordatenbanken und ist das Ergebnis komplexer Mathematik.

Vektoren statt echter Erinnerung

Hierzu forscht Professorin Ute Schmid an der Universität Bamberg. Als Expertin für Erklärbare KI macht sie deutlich: „Das System erinnert sich nicht im menschlichen Sinne. Private Informationen werden in numerische Werte – sogenannte Vektoren – übersetzt.“ In einem hochdimensionalen Raum berechnet die KI Ähnlichkeiten zwischen aktuellen Eingaben und gespeicherten Daten. Dieser mathematische Abgleich ermöglicht es dem Bot, Informationen blitzschnell abzurufen. „Für den Nutzenden entsteht der Eindruck eines Gegenübers, das lernt. Technisch gesehen ist es jedoch ein statistischer Prozess der Mustererkennung“, so Schmid.

Das „Daten-Vampir“-Problem

•Warum „Vampire“? Anbieter wie Replika oder Chai sammeln private Daten (mentale Gesundheit, Traumata) und nutzen diese für Werbeprofile.

•Das BSI warnt: Einmal im „Vektorgedächtnis“, lassen sich Daten kaum löschen. Es droht ein dauerhafter Kontrollverlust über die eigene digitale Identität.

•Rechtliche Grauzone: Da die Server oft in den USA stehen, bietet die europäische DSGVO nur begrenzten Schutz

Vom Vertrauen zur Handelsware

Die beschriebene mathematische Analyse privater Informationen bildet das Rückgrat eines riskanten Geschäftsmodells. Da die KI durch die Vektordatenbanken ein exaktes psychologisches Profil des Nutzenden erstellt, werden die preisgegebenen Geheimnisse zur wertvollen Handelsware. Professorin Katharina Zweig warnt in ihrem Werk „Ein Algorithmus hat kein Taktgefühl“ vor der sogenannten „Blackbox-Problematik“: Während der Mensch glaubt, in einem geschützten Raum zu kommunizieren, werden die Daten im Hintergrund analysiert, um Modelle zu trainieren oder Profile für Werbetreibende zu schärfen. Die Speicherung dieser „Vektorgedächtnisse“ erfolgt meist auf Servern in den USA, wodurch der Zugriff der europäischen Datenschutzbehörden erschwert wird. Analysen der Mozilla Foundation bestätigen, dass viele Anbieter als „Daten-Vampire“ fungieren, die sensible Informationen unbegrenzt vorhalten. Das Bundesamt für Sicherheit in der Informationstechnik (BSI) warnt in diesem Zusammenhang vor einem „dauerhaften Kontrollverlust“ über die eigene digitale Identität.

Teaserbild: Datenübertragung zwischen Mensch und KI // Bild: Ayse Can