Autonom fahrende Taxis und Busse könnten nach Einschätzung von Fachleuten innerhalb der nächsten zehn Jahren in Deutschland zu sehen sein. Technikjournal beleuchtet den aktuellen Stand der Technik, zeigt Herausforderungen auf und erklärt die fünf Stufen des autonomen Fahrens. // Von Kasimir Hupe und Philipp Essipov

Die Einführung von autonomen Fahrsystemen im deutschen Straßenverkehr wird nach Expertenmeinungen noch dauern. So könnten sich kommerziell eingesetzte Nutzfahrzeuge, die automatisiert zwischen Logistikzentren pendeln, sowie Robo-Taxis und andere People-Mover in den nächsten Jahren durchsetzen. Johannes Feiler, Mitarbeiter des Lehrstuhls für Fahrzeugtechnik der Technischen Universität München (TUM) geht davon aus, dass es "auf gesperrten oder geschlossenen Gebieten wie großen Firmengeländen, Messegeländen oder Kliniken in den nächsten 10 Jahren zu einem Einsatz von autonom fahrenden Autos kommen wird." In öffentlichen Gebieten, wie zum Beispiel Innenstädten mit vielen Fußgängern, kann es noch länger dauern bis dort autonom fahrende Autos ohne Sicherheitsfahrer zu sehen sind. Julian Schindler, Gruppenleiter für System-Automation und Integration am DLR-Institut für Verkehrssystemtechnik, sagt dazu: "Dass Robo-Taxis auf nicht vorab definierten Strecken, also frei wie durch Menschen gesteuerte Fahrzeuge fahren können, wird aus unserer Sicht aufgrund der vielfältigen technischen Herausforderungen noch einige Jahre dauern."

Fünf Stufen zum vollautonomen Robo-Taxi

Um den aktuellen Stand der Technik näher beleuchten zu können, müssen erst die international anerkannten Stufen des autonomen Fahrens betrachtet werden. Eine Klassifizierung und Definition von Begriffen für Fahrzeuge mit Systemen zum automatisierten Fahren führte die Society of Automotive Engineers (SAE) bereits 2016 ein. Die Einstufung in fünf Level wird auch heute noch weitestgehend benutzt. Fahrerlose Robo-Taxis und People-Mover gibt es erst ab Stufe vier. Mit der Hilfe von Tom und seinem Taxi definiert das folgende Video die unterschiedlichen Stufen des autonomen Fahrens. Visualisierte Beispiele zeigen die Unterschiede der einzelnen Stufen im Detail.

ADAC und BASt wünschen sich Vereinfachung der Stufen

Der ADAC und die Bundesanstalt für Straßenwesen (BASt) wünschen sich schon länger, dass das System für eine vereinfachte Nutzerkommunikation auf drei Stufen heruntergebrochen wird. Fachleute weisen auf Überschneidungen innerhalb der von der SAE definierten fünf Stufen hin. Diese können im Dialog mit der Öffentlichkeit Unklarheiten erzeugen. Bei einer Einteilung in drei Stufen gäbe es dann nur noch assistiertes Fahren (Level 1+2), automatisiertes Fahren (Level 3) und autonomes Fahren (Level 4+5). Die drei verschiedenen Fahrerrollen sollen den Nutzenden klarmachen, welche Aufgabe er im Fahrzeug hat und somit Missverständnisse vorbeugen.

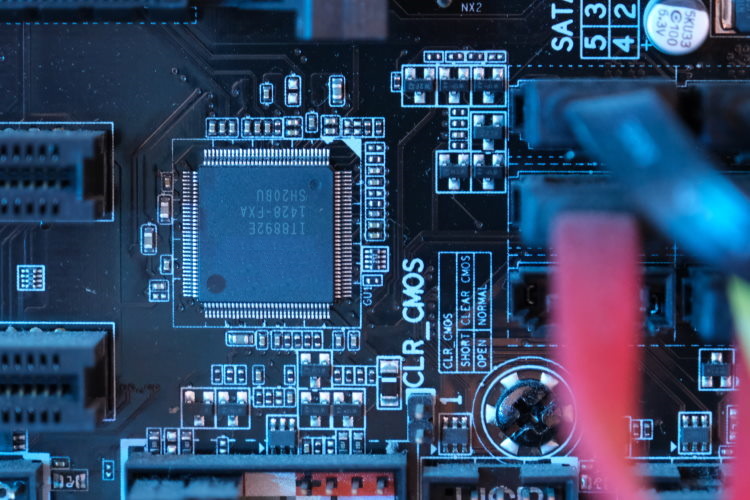

Essentielle Hardware für Robo-Taxis

Kameras, die am Auto nach vorne, hinten und zur Seite gerichtete sind, haben die höchste Auflösung von allen angebrachten Sensoren. Die von den Kameras und der Computer-Vision-Software verarbeiteten Daten helfen, detaillierte Informationen über die Umgebung des Autos zu erkennen. Ergänzend greifen autonome Autos besonders bei schlechter Sicht auf Radardaten zu. Dadurch können sie Informationen über die Entfernung, Richtung und Geschwindigkeit von Objekten abrufen. Die dritte Technologie an Bord ist oft LiDAR. Im Vergleich zu Radar hat LiDAR eine viel höhere Auflösung. LiDAR-Sensoren senden Laser anstelle von Radiowellen aus , um die Umgebung des Fahrzeugs zu erkennen und abzubilden. Bei Witterungsbedingungen wie Schnee, Nebel oder Smog arbeiten die Laserstrahlen noch nicht sehr genau. "Jedes Sensorsystem hat seine Vor- und Nachteile. Um Fehldetektionen zu vermeiden, ist eine Kopplung mehrerer Sensortypen unumgänglich", so Julian Schindler vom DLR.

Komplementäre Sensoren

Heutzutage sind selbstfahrende Autos mit Hardware für die GPS-Verfolgung und Ultraschallsensoren für die Objekterkennung ausgerüstet. Hinzu kommen Sensoren zur Messung der Geschwindigkeit des Autos. Ein oft übersehener, aber wichtiger Sensor für selbstfahrende Autos ist ein Mikrofon zur Verarbeitung von Audioinformationen. Dies ist entscheidend, um zum Beispiel einem Einsatzfahrzeug auszuweichen. Das System kann so auch einen Unfall in der Nähe erkennen, der eine Gefahr für das Fahrzeug darstellen könnte.

Ohne genug Rechenpower geht nichts

Damit die Software in Echtzeit mit den Hardwarekomponenten zusammenarbeiten und alle Sensordaten effizient verarbeiten kann, benötigt sie einen Computer mit ausreichender Rechenleistung. Graphical Processing Units (GPU) sind zum Standard für viele selbstfahrende Autos geworden. Durch immer größer werdende Datenmengen stoßen GPUs aber mittlerweile an ihre Grenzen und sind nicht die ideale Lösung. Neural Network Accelerator (NNA), die 2019 von Tesla in ihrem Full Self-Driving Chip vorgestellt wurden, verfügen über eine weitaus größere Rechenleistung für die Verarbeitung von Echtzeitdaten der verschiedenen Kameras und Sensoren. Laut Tesla vergleichen sich diese Chips bei der Verarbeitung von 35 Milliarden GOPS (Giga-Operationen pro Sekunde) folgendermaßen:

CPU: 1.5

GPU: 17

NNA: 2100

Teslas Autopilot Hardware hat seine Augen überall (Quelle: Tesla)

Herausforderungen für vollautonomes Fahren

Menschen haben den großen Vorteil, dass sie mit anderen Verkehrsteilnehmern interagieren und kooperieren können. Als geschulte Problemlöser können sie komplexe Situationen im Verkehr bewältigen. Die Auffassungsgabe und die nonverbale Kommunikation sind hier menschliche Stärken. Autonome Fahrzeuge können sich theoretisch per Mobilfunk oder WLAN mit anderen Fahrzeugen oder Datenquellen austauschen (C2X-Kommunikation). So können sie sich zum Beispiel gegenseitig vor bevorstehenden Hindernissen oder Gefahren warnen. Ein weiteres Beispiel, das Schindler vom DLR anbringt, ist die "Kamera an einer Straßenecke die es dem Fahrzeug beispielsweise ermöglichen kann, um die Ecke zu schauen." In der Praxis sind die Technologien in den Autos und die Infrastruktur im öffentlichen Bereich hierfür aber noch nicht ausreichend ausgebaut und entwickelt.

Das fehlende Puzzlestück

Robo-Taxis nutzen eine Kombination aus Kameras, Radar, LiDAR und andere Sensoren, um ihre Umgebung zu verstehen. Die Wahrscheinlichkeit, dass ein Ausfall eines einzelnen Hardwaresystems das autonom fahrende Auto funktionsunfähig macht, ist also extrem gering. "Das Problem ist nicht mehr in der Erfassung der Umgebung, sondern in der Interpretation", so Andreas Knie, Professor für Soziologie an der Technischen Universität (TU) Berlin. "Aktuell liegt die größte Schwäche von selbstfahrenden Autos in der Software." Die Deep-Learning-Algorithmen werden anhand von realen Fahrten und Simulationen trainiert, aber selbst nach Milliarden von Kilometern von gesammelten Daten gibt es immer noch seltene Situationen, mit denen die Lernmodelle nicht umgehen können. Johannes Feiler von der TUM sagt hierzu: "Ein Restrisiko wird bleiben. Es geht nur um ein vertretbares Risiko. Dieses muss auch gesellschaftlich noch geklärt werden." Darüber hinaus erschweren regionale Unterschiede im Verkehrswesen das Erlernen aller nur möglichen Situationen im Straßenverkehr.

Teaserbild: Autonomes Taxi // Quelle: Adobe Stock - fotomek

Die Autoren

Kasimir Hupe

Philipp Essipov