Wo endet wissenschaftliches Arbeiten, wo beginnt Betrug? Moderne Plagiatssoftware soll im KI-Zeitalter für Sicherheit sorgen. Dieser Beitrag erklärt, wie solche Programme arbeiten, wo ihre Grenzen liegen und warum am Ende immer Menschen über die Eigenleistung entscheiden müssen. // Seymanur Uzun

Plagiat bezeichnet in der Wissenschaft die Übernahme fremder Gedanken oder Texte ohne korrekte Quellenangabe und verstößt gegen die Regeln der guten wissenschaftlichen Praxis. Diese sollen sicherstellen, dass klar erkennbar ist, was eine eigene Leistung ist und was aus anderen Arbeiten stammt. Wie ernst Hochschulen solche Verstöße nehmen, zeigt ein Fall aus dem Jahr 2024: Die Universität Rostock entzog der Politikerin Manja Schreiner den Doktortitel. Eine Prüfung ihrer 17 Jahre alten Dissertation ergab, dass viele Textstellen nicht korrekt gekennzeichnet waren. Der Fall zeigt, dass Plagiatsvorwürfe auch Jahre später Folgen haben können. Zudem reicht es nicht aus, fremde Inhalte nur umzuschreiben. Auch sinngemäße Übernahmen gelten als Plagiat, wenn die Quelle fehlt. Mit generativer KI wird dieses Problem größer, da Texte heute leicht umformuliert oder neu erstellt werden können.

Wie die Plagiatssoftware arbeitet

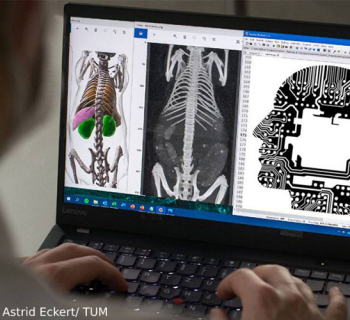

Plagiatssoftware prüft Texte mit verschiedenen technischen Methoden. Ein verbreiteter Ansatz ist das sogenannte Shingling. Dabei wird ein Text in kurze Wortgruppen zerlegt und mit großen Datenbanken verglichen. Finden sich gleiche oder sehr ähnliche Textstellen, markiert die Software diese als auffällig. Wie das funktioniert, erklärt das folgende Video:

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Moderne Programme suchen nicht mehr nur nach identischen Sätzen. Wenn keine direkten Treffer vorliegen, analysieren sie den Aufbau von Sätzen oder typische Formulierungen. So sollen auch stark umgeschriebene Textstellen erkannt werden. Am Ende entsteht meist ein Bericht mit Prozentwerten und Markierungen. Diese Zahlen werden oft falsch verstanden. Sie sind keine Beweise, sondern lediglich Hinweise, die fachlich eingeordnet werden müssen. Darauf weist auch die Plagiatsforscherin Debora Weber-Wulff hin. Sie ist Informatikerin und Professorin im Ruhestand an der Hochschule für Technik und Wirtschaft Berlin und gilt als eine der bekanntesten Expertinnen für Plagiatserkennung im deutschsprachigen Raum. In ihrem "Handbook of Academic Integrity" betont sie, dass solche Verfahren keine eindeutigen Ergebnisse liefern. Software könne kein Plagiat beweisen, sondern lediglich Textstellen markieren, die genauer geprüft werden sollten. Ob tatsächlich ein Fehlverhalten vorliegt, muss immer von Menschen entschieden werden.

Der Software-Markt – Welches Programm findet was?

Wer Texte auf Plagiate prüfen möchte, kann zwischen professioneller Software für Hochschulen und frei verfügbaren Online-Tools wählen. Für diesen Beitrag wurden Programme betrachtet, die im deutschsprachigen Hochschulbereich besonders häufig genutzt oder beworben werden.

Ein wichtiger Unterschied ist die Verfügbarkeit. Manche Systeme können nur über Hochschulen genutzt werden, andere stehen Privatpersonen gegen Bezahlung zur Verfügung. Auch die Referenzdatenbanken unterscheiden sich. Einfache Tools durchsuchen vor allem frei zugängliche Internetseiten. Professionelle Programme greifen zusätzlich auf Fachverlage oder frühere studentische Arbeiten zu. Viele Anbieter werben außerdem mit KI-Funktionen. Diese sollen Hinweise darauf liefern, ob ein Text typische Merkmale maschineller Sprache zeigt. Auch hier gilt: Die Ergebnisse liefern Anhaltspunkte, aber keine sicheren Beweise.

Von Textkopien zu KI-Analyse

Aussagekraft von Plagiatssoftware

Ob diese Verfahren die Plagiatsprüfung tatsächlich verbessern, ist umstritten. Die Plagiatsforscherin Debora Weber-Wulff warnt davor, den Ergebnissen zu viel Gewicht beizumessen. Auch moderne Programme könnten nicht sicher feststellen, wer einen Text geschrieben hat. Sie markieren lediglich Stellen, die auffällig erscheinen und genauer geprüft werden sollten.

Rolle der menschlichen Prüfung

Aus informatischer Sicht zeigen sich ebenfalls klare Grenzen. Die Informatiker Benno Stein, Professor an der Bauhaus-Universität Weimar, und Martin Potthast, Professor an der Universität Kassel, betonen, dass Software keinen Vorsatz nachweisen kann. Ihr Nutzen liege vor allem darin, große Textmengen zu sichten und mögliche Verdachtsfälle automatisch zu identifizieren. Die fachliche Bewertung müsse anschließend durch Menschen erfolgen. Zudem lasse sich technisch nicht eindeutig beantworten, ab welchem Grad sprachlicher oder inhaltlicher Veränderung eine eigenständige Leistung vorliegt. Eine Veröffentlichung aus dem Jahr 2024 kommt zu dem Ergebnis, dass eine zuverlässige Unterscheidung zwischen KI-generierten und menschlich verfassten Texten grundsätzlich nicht möglich ist.

Plagiatssoftware ist kein Beweis

Mit der zunehmenden Nutzung von KI in Studium und Wissenschaft geraten bestehende Prüfungs- und Bewertungsregeln unter Druck. Fachleute betonen, dass es dabei weniger um neue Kontrollsoftware geht als um klare und faire Rahmenbedingungen für den Einsatz digitaler Werkzeuge. Debora Weber-Wulff weist darauf hin, dass Plagiatssoftware kein objektives Beweisinstrument ist. Programme können lediglich auffällige Textstellen anzeigen. Entscheidungen über Täuschung oder Fehlverhalten müssen weiterhin von Menschen getroffen werden. Softwareergebnisse dürften daher nicht automatisch zu Vorwürfen führen, sondern müssten immer fachlich eingeordnet werden.

Zukunft von Lehre und Prüfung

Einen anderen Schwerpunkt setzt die KI-Expertin Doris Weßels. In einem Interview mit Sarah Loos und Anja Diekötter, veröffentlicht am 28.01.2025, spricht sie gemeinsam mit Stefan Schönwetter, Experte für Digitale Bildung bei der Deutschen Kinder- und Jugendstiftung (DKJS), über die Potenziale und Grenzen von KI-Systemen in der Bildung. Sie macht deutlich, dass die zentrale Herausforderung nicht darin liegt, die Nutzung von KI zu verhindern. Entscheidend sei vielmehr, Transparenz zu schaffen und einen kompetenten sowie kritischen Umgang mit diesen Werkzeugen zu vermitteln.

In dem Diskussionspapier "Wissenschaftliche Abschlussarbeiten im KI-Zeitalter" betont Weßels, dass es dafür Prüfungs- und Bewertungsformen brauche, die diesen Umgang sichtbar und nachvollziehbar machen. Zudem unterstreicht sie die Notwendigkeit klarer Spielregeln, transparenter Erwartungen sowie einer Weiterentwicklung von Lehre und Prüfungen, um den neuen technischen Möglichkeiten gerecht zu werden.

Teaserbild: Illustration zu Plagiatssoftware im Wissenschaftskontext // Bild: Seymanur Uzun